2025年11月29日 07:00

発行 第7587号

1998年今から17年前、自分が立ち上げた、ちっぽけなひとりごとのようなホームページが、このサイトのスタートでもあります。

それから1年、1999年に独自ドメインを取得し、1台丸々専用サーバを立ち上げました。その頃は、サーバの設定や意味も全くわからずのスタートでした。

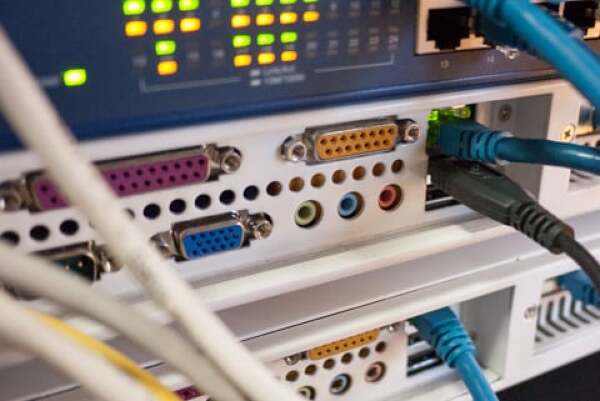

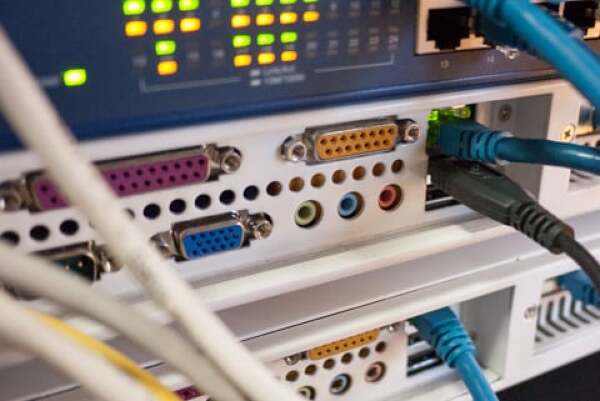

(Webサーバ)

今号はスーパーマーケットや商業以外の話題から、このサイトを運営している者の、10年超に及ぶ、自作サーバの経験をまとめてみたいと思います。

サイト運営当初は、サーバ業者の方にお任せする形で、専用サーバを立上げ、その台数がドンドン増えていきました。

15年前のパソコンのスペックって言うのは、本当今と比べ物にならないくらい、非力でしてね。

とにかく台数が増えていく一方でした。

サーバ運営に必要な知識というのは、その時のサーバ業者の担当者さんから、色々教えていただく事が出来たので、それをきっかけに、自分でも、参考書など知識を得る事が出来ましてね。

もちろん今の時代はネットで調べられる時代です。

その当時のLinuxというのは、今程簡単ではなく、slackwareを使っていましたが、httpサーバもダウンロードして、コンパイル、インストールなんて、凄く面倒な作業だったのです。

ある日、slackware以外にもRedhatと言う画期的なOSが登場します。

プログラムをダウンロードして、コマンドを打つだけで、サーバのソフトウェアがインストール出来るのです。

そのような事情の変化もあり、コスト削減もしたく、運営しているサーバの中から、通信帯域を使っていないサーバを使い、自分でサーバを作り、自分でサーバルームを立ち上げて見ようと思った事がきっかけです。

そして、中古パソコンを買ってきて、試験を始めてみました。

1)サーバルーム第1世代

初めてのサーバルームは、事務所の端っこにパーティションで区切って、ラックを置いて、サーバを立ち上げる形です。

サーバと言っても、ぶっちゃけ自作パソコンにLinuxOSをインストールして、サーバを立ち上げるくらいだったのですね。

この頃のOSはまだ、Redhatでしたね。

この構成でも5年くらいは運営しました。

この時の経験として、分かった事…。

・夏はエアコンで23度維持させないと、ものすごく暑くなる

これを元に夏は良かったのですが、何故か冬の朝、早朝にサーバが落ちる事がしばしば…。

・冬は湿度が低くなると静電気の発生で、サーバが落ちる。

と言う結論に達しました。

自作サーバを運営していて、壊れやすかった消耗品としましては…。

・HDDが壊れやすい(言われるほどでは無いけれど)

・ファンからの異音が発生し易い(そのまま放置するとファンが止まります)

・電源が壊れる事がある

一度だけ落雷で、マザーボードが壊れた事がありましたが、データなどは無事で、マザーボードの交換で復旧しました。

HDDはですね。思ったほど壊れることは無かったですけど、RAIDを組んでいると、頻繁に不安定になりやすかったです。

この頃からLinuxのOSにも、色々事情の変化がありまして、Redhatが完全有料化。

必然的に無料版LinuxはFedoraへと言う流れだったのですね。

でも、Fedoraは開発向けOSで、とにかくリリースが早く、LinuxOSを新しく切り替え必要が出てきたのです。

結果Debian、CentOSなどを使う形になります。

個人的にはDebianがお気に入りです。

これらの経験を元にですね。

本格的に、事務所周辺の地域でも、高速回線を引くことが出来るようになり、全サーバを自作サーバで稼働させる決意をするのです。

2)サーバルーム第2世代

(DELLサーバ)

事務所以外にサーバをおける所を準備しまして、サーバを稼働させる為に安定した環境を構築することにしました。

・温度管理の徹底

空調機の導入 (多機能は要らないので、シンプルな空調機)

・湿度管理の徹底

温湿度計をサーバにセンサー取付、吸気と排気のあたりでサーバにて温湿度を管理

冬は加湿器を持込

・防塵対策

一時期防塵工場に居たので、この辺りはどうすればいいのかわかる者でした。

むやみに人の出入りをなくす。

大型空気清浄機の導入です。

その他諸々。

初めて構築したサーバルームに、42Uラックと言う大型ラックを搬入させまして、DELLサーバを購入し、はじめはメーカー製サーバで稼働開始です。

流石に安定していました。

8年間稼働させましたが、設計10年なので、超安定ですね。

ホコリの具合も分かりますよね。

8年間も普通の部屋でパソコンを稼働させると、ファンの所のホコリがスゴイですよね。

だいぶ第2世代のサーバルームも安定してきたので、全サーバを稼働させる為に、ここで自作サーバに切り替えます。

(バラックサーバ)

構築したサーバがこれです。

通称バラックケース。

バローホームセンターで買ってきた、ラックの棚の反対側にサーバの部品を置くだけ。

この頃多くの企業が、自社のサーバ環境を発表する機会があり、Googleのサーバも日本の国内の大手業者のサーバも、皆ケースをむき出しで稼働させていたのですね。

それに刺激されました。

マザーボードに、HDD、SSD、電源、スイッチ関係

これだけでサーバができちゃうんです。

実際はマザーボードの下にはアクリルの板があります。

また、このサーバケースには、通電対策もしてありまして、感電した時、他のサーバに影響を与えないようにしておきました。

そして、アメリカから輸入したSSD。まだ日本では、SSDは高価な物だったのです。

丁度円高だったこともあり、それなりにお安く購入出来ました。

しかも、ケースに入っていないから、ケースファンも必要無しです。

HDDのファンだけは、今までの経験から、取り付けていました。

42Uラックにとりつける場合、高さは4Uくらい使いますが、手前と奥で2台入ります。

実際このバラックケースのサーバで、6~7年くらい稼働させましたが、故障無しです。

サーバルームの作り方と最近のパソコンパーツの安定性の向上のおかげですね。

新サーバルームで、壊れた物といえば…。

・メーカーから買ったラックサーバの電源

・ネットワーク機器

でした。

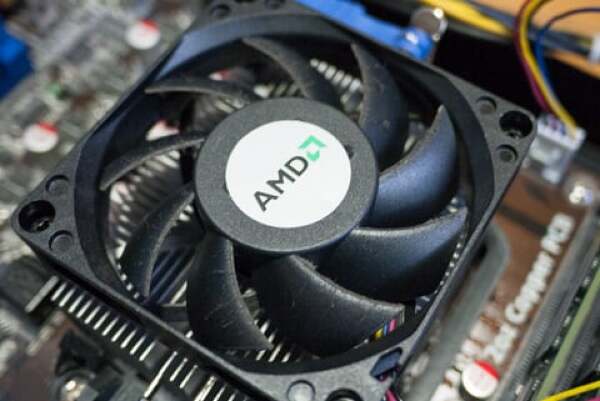

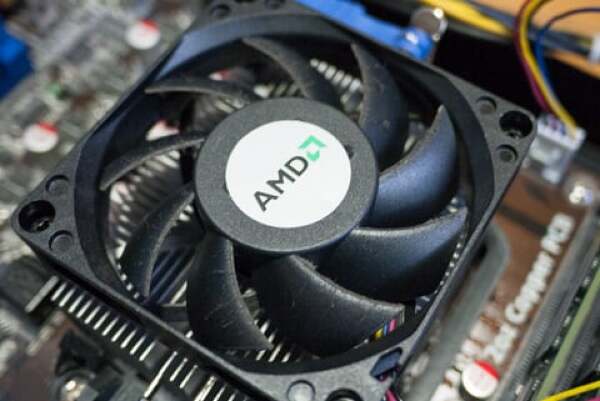

(CPUファン)

CPUファンにもホコリがこれだけ。

6~7年も回りっぱなしだったのに、それなりに防塵対策も良かったようです。

自作サーバ・自作サーバルームを経験し、運が良かったのか分かりませんが、とにかく10年を超える運営をして、一番の苦労は精神的苦痛です。

サーバを稼働させる為には、何よりも電気が必要です。

夏は雷により瞬間電圧降下が発生し、冬の停電は恐ろしく、断線系が多いので長期に及びます。

これらの電源確保の為に、サーバにはUPSと言う補助電源があります。

UPSも当初はAPC製の大型UPSを使っていたのですが、とにかく高い。

でも、8年くらいは持ちましたね。

第2世代サーバルームを構築するに当たり、その頃何かと資源の物価もあがっていたので、APC製UPSが前ほど出回らなくなっていたのですね。

そこで他社様のサーバルーム公開で、ふと見たUPS。

楽器メーカーでお馴染みのサウンドハウスさんのUPSです。

自分もサウンドハウスのUSPを大量に購入しました。

サウンドハウスさんのUPSは、注意書きがある通り、2~3年でバッテリーが持たなくなります。

実際に使ってみまして、2年~3年で本当に使い物にならなくなります。

バッテリーが弱ったり、中には割れたりするのもあります。

APCの場合、こうなったら、警告などの案内がありますが、サウンドハウスのUPSにはこういう通知機能は無いのですね。

コストを下げる為に、自作サーバルームに移って10年。

実はですね。

今インターネットの世界では、サーバ業界は、仮想化・クラウドと言う分野に移り始めています。

これはCPUの多コア化に由来する物なのですけど、とにかく10年前のスペックとは比べ物にならない仮想サーバが、安価に提供される時代です。

15年専用サーバを稼働させましたけど、これを機に、全て仮想サーバに切り替えました。

実際この日記のサーバも、↑のバラックサーバから、仮想サーバに切り替わっています。

10年超に及ぶ運営で、一番困ったのは…。

・ネットワーク機器の故障による障害

原因特定に時間がかかりやすいです。

・機器がいつ壊れるか分からない、停電がいつ発生するか分からない不安感

現在これらの不安感は、非情に軽減されました。

これで他の事に集中出来ます。

これからサーバを稼働させてみたい。

サーバ運営をしてみたい。

そんな人に少しでも参考になればと思い、読み物的に執筆してみました。

それから1年、1999年に独自ドメインを取得し、1台丸々専用サーバを立ち上げました。その頃は、サーバの設定や意味も全くわからずのスタートでした。

(Webサーバ)

今号はスーパーマーケットや商業以外の話題から、このサイトを運営している者の、10年超に及ぶ、自作サーバの経験をまとめてみたいと思います。

サイト運営当初は、サーバ業者の方にお任せする形で、専用サーバを立上げ、その台数がドンドン増えていきました。

15年前のパソコンのスペックって言うのは、本当今と比べ物にならないくらい、非力でしてね。

とにかく台数が増えていく一方でした。

サーバ運営に必要な知識というのは、その時のサーバ業者の担当者さんから、色々教えていただく事が出来たので、それをきっかけに、自分でも、参考書など知識を得る事が出来ましてね。

もちろん今の時代はネットで調べられる時代です。

その当時のLinuxというのは、今程簡単ではなく、slackwareを使っていましたが、httpサーバもダウンロードして、コンパイル、インストールなんて、凄く面倒な作業だったのです。

ある日、slackware以外にもRedhatと言う画期的なOSが登場します。

プログラムをダウンロードして、コマンドを打つだけで、サーバのソフトウェアがインストール出来るのです。

そのような事情の変化もあり、コスト削減もしたく、運営しているサーバの中から、通信帯域を使っていないサーバを使い、自分でサーバを作り、自分でサーバルームを立ち上げて見ようと思った事がきっかけです。

そして、中古パソコンを買ってきて、試験を始めてみました。

1)サーバルーム第1世代

初めてのサーバルームは、事務所の端っこにパーティションで区切って、ラックを置いて、サーバを立ち上げる形です。

サーバと言っても、ぶっちゃけ自作パソコンにLinuxOSをインストールして、サーバを立ち上げるくらいだったのですね。

この頃のOSはまだ、Redhatでしたね。

この構成でも5年くらいは運営しました。

この時の経験として、分かった事…。

・夏はエアコンで23度維持させないと、ものすごく暑くなる

これを元に夏は良かったのですが、何故か冬の朝、早朝にサーバが落ちる事がしばしば…。

・冬は湿度が低くなると静電気の発生で、サーバが落ちる。

と言う結論に達しました。

自作サーバを運営していて、壊れやすかった消耗品としましては…。

・HDDが壊れやすい(言われるほどでは無いけれど)

・ファンからの異音が発生し易い(そのまま放置するとファンが止まります)

・電源が壊れる事がある

一度だけ落雷で、マザーボードが壊れた事がありましたが、データなどは無事で、マザーボードの交換で復旧しました。

HDDはですね。思ったほど壊れることは無かったですけど、RAIDを組んでいると、頻繁に不安定になりやすかったです。

この頃からLinuxのOSにも、色々事情の変化がありまして、Redhatが完全有料化。

必然的に無料版LinuxはFedoraへと言う流れだったのですね。

でも、Fedoraは開発向けOSで、とにかくリリースが早く、LinuxOSを新しく切り替え必要が出てきたのです。

結果Debian、CentOSなどを使う形になります。

個人的にはDebianがお気に入りです。

これらの経験を元にですね。

本格的に、事務所周辺の地域でも、高速回線を引くことが出来るようになり、全サーバを自作サーバで稼働させる決意をするのです。

2)サーバルーム第2世代

(DELLサーバ)

事務所以外にサーバをおける所を準備しまして、サーバを稼働させる為に安定した環境を構築することにしました。

・温度管理の徹底

空調機の導入 (多機能は要らないので、シンプルな空調機)

・湿度管理の徹底

温湿度計をサーバにセンサー取付、吸気と排気のあたりでサーバにて温湿度を管理

冬は加湿器を持込

・防塵対策

一時期防塵工場に居たので、この辺りはどうすればいいのかわかる者でした。

むやみに人の出入りをなくす。

大型空気清浄機の導入です。

その他諸々。

初めて構築したサーバルームに、42Uラックと言う大型ラックを搬入させまして、DELLサーバを購入し、はじめはメーカー製サーバで稼働開始です。

流石に安定していました。

8年間稼働させましたが、設計10年なので、超安定ですね。

ホコリの具合も分かりますよね。

8年間も普通の部屋でパソコンを稼働させると、ファンの所のホコリがスゴイですよね。

だいぶ第2世代のサーバルームも安定してきたので、全サーバを稼働させる為に、ここで自作サーバに切り替えます。

(バラックサーバ)

構築したサーバがこれです。

通称バラックケース。

バローホームセンターで買ってきた、ラックの棚の反対側にサーバの部品を置くだけ。

この頃多くの企業が、自社のサーバ環境を発表する機会があり、Googleのサーバも日本の国内の大手業者のサーバも、皆ケースをむき出しで稼働させていたのですね。

それに刺激されました。

マザーボードに、HDD、SSD、電源、スイッチ関係

これだけでサーバができちゃうんです。

実際はマザーボードの下にはアクリルの板があります。

また、このサーバケースには、通電対策もしてありまして、感電した時、他のサーバに影響を与えないようにしておきました。

そして、アメリカから輸入したSSD。まだ日本では、SSDは高価な物だったのです。

丁度円高だったこともあり、それなりにお安く購入出来ました。

しかも、ケースに入っていないから、ケースファンも必要無しです。

HDDのファンだけは、今までの経験から、取り付けていました。

42Uラックにとりつける場合、高さは4Uくらい使いますが、手前と奥で2台入ります。

実際このバラックケースのサーバで、6~7年くらい稼働させましたが、故障無しです。

サーバルームの作り方と最近のパソコンパーツの安定性の向上のおかげですね。

新サーバルームで、壊れた物といえば…。

・メーカーから買ったラックサーバの電源

・ネットワーク機器

でした。

(CPUファン)

CPUファンにもホコリがこれだけ。

6~7年も回りっぱなしだったのに、それなりに防塵対策も良かったようです。

自作サーバ・自作サーバルームを経験し、運が良かったのか分かりませんが、とにかく10年を超える運営をして、一番の苦労は精神的苦痛です。

サーバを稼働させる為には、何よりも電気が必要です。

夏は雷により瞬間電圧降下が発生し、冬の停電は恐ろしく、断線系が多いので長期に及びます。

これらの電源確保の為に、サーバにはUPSと言う補助電源があります。

UPSも当初はAPC製の大型UPSを使っていたのですが、とにかく高い。

でも、8年くらいは持ちましたね。

第2世代サーバルームを構築するに当たり、その頃何かと資源の物価もあがっていたので、APC製UPSが前ほど出回らなくなっていたのですね。

そこで他社様のサーバルーム公開で、ふと見たUPS。

楽器メーカーでお馴染みのサウンドハウスさんのUPSです。

自分もサウンドハウスのUSPを大量に購入しました。

サウンドハウスさんのUPSは、注意書きがある通り、2~3年でバッテリーが持たなくなります。

実際に使ってみまして、2年~3年で本当に使い物にならなくなります。

バッテリーが弱ったり、中には割れたりするのもあります。

APCの場合、こうなったら、警告などの案内がありますが、サウンドハウスのUPSにはこういう通知機能は無いのですね。

コストを下げる為に、自作サーバルームに移って10年。

実はですね。

今インターネットの世界では、サーバ業界は、仮想化・クラウドと言う分野に移り始めています。

これはCPUの多コア化に由来する物なのですけど、とにかく10年前のスペックとは比べ物にならない仮想サーバが、安価に提供される時代です。

15年専用サーバを稼働させましたけど、これを機に、全て仮想サーバに切り替えました。

実際この日記のサーバも、↑のバラックサーバから、仮想サーバに切り替わっています。

10年超に及ぶ運営で、一番困ったのは…。

・ネットワーク機器の故障による障害

原因特定に時間がかかりやすいです。

・機器がいつ壊れるか分からない、停電がいつ発生するか分からない不安感

現在これらの不安感は、非情に軽減されました。

これで他の事に集中出来ます。

これからサーバを稼働させてみたい。

サーバ運営をしてみたい。

そんな人に少しでも参考になればと思い、読み物的に執筆してみました。

あわせて読みたい記事

2025年11月28日 07:00

2025年11月27日 07:00

2025年11月26日 07:00

2025年11月25日 07:00

2025年11月24日 07:00

2025年11月23日 07:00

2019年01月03日 07:00

2017年08月23日 07:00

2010年10月31日 07:00

この記事についてフィードバッグ

「こんな環境でした!サーバを自作で稼働させ10年超のまとめ」の記事につきまして、ご意見・フィードバックなどありましたら、お気軽にお問い合わせください。

また、全体のお問い合わせや、岐阜県にてお店のオープン情報などもお気軽に教えてください。(自薦他薦問わず)

また、全体のお問い合わせや、岐阜県にてお店のオープン情報などもお気軽に教えてください。(自薦他薦問わず)

今読まれている記事

11月28日 07:00

11月29日 07:00

11月27日 07:00

11月22日 07:00

04月07日 17:00

03月23日 07:00

10月31日 07:00

このページは何?

コラム更新日記とは、地元住みのライターがお届けする、地元のワクワク共有サイトです。

岐阜を中心とした中部のスーパーマーケットや商業施設の最新情報や店舗レポートなど、地域の商業動向を詳しく紹介しています。

毎日記事を更新していますので、ぜひブックマークしてお楽しみください!

このレポートは、筆者が現地で調査した結果を基に作成されています。

一次取材/撮影:かぴばら

岐阜を中心とした中部のスーパーマーケットや商業施設の最新情報や店舗レポートなど、地域の商業動向を詳しく紹介しています。

毎日記事を更新していますので、ぜひブックマークしてお楽しみください!

このレポートは、筆者が現地で調査した結果を基に作成されています。

一次取材/撮影:かぴばら

重要なことは下記リンクをご覧ください: